Anyscale

1.1 设置与日志记录

""" OPENAI PYTHON SDK """

import openai

PORTKEY_GATEWAY_URL = "https://api.portkey.ai/v1"

PORTKEY_HEADERS = {

'Authorization': 'Bearer ANYSCALE_KEY',

'Content-Type': 'application/json',

# **************************************

'x-portkey-api-key': 'PORTKEY_API_KEY', # Get from https://app.portkey.ai/,

'x-portkey-provider': 'anyscale' # Tell Portkey that the request is for Anyscale

# **************************************

}

client = openai.OpenAI(base_url=PORTKEY_GATEWAY_URL, default_headers=PORTKEY_HEADERS)

response = client.chat.completions.create(

model="mistralai/Mistral-7B-Instruct-v0.1",

messages=[{"role": "user", "content": "Say this is a test"}]

)

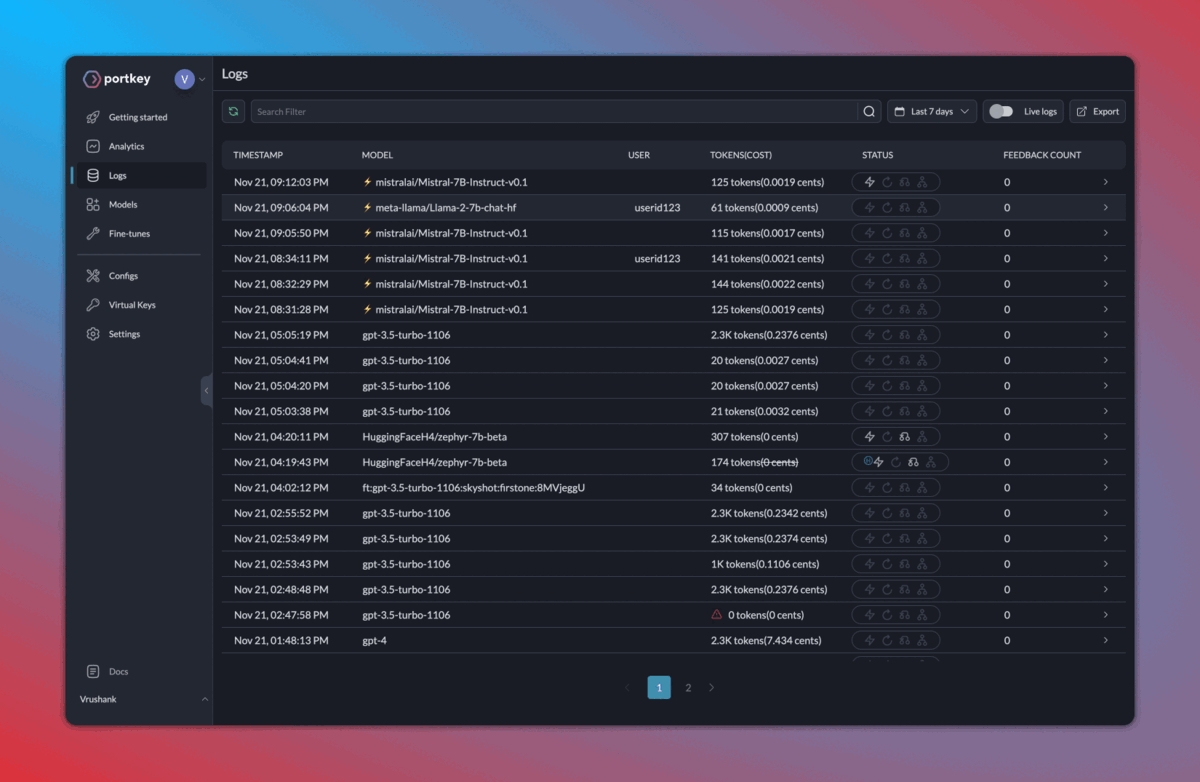

print(response.choices[0].message.content)1.2. 增强可观察性

2. 缓存、回退、负载均衡

3. 收集反馈

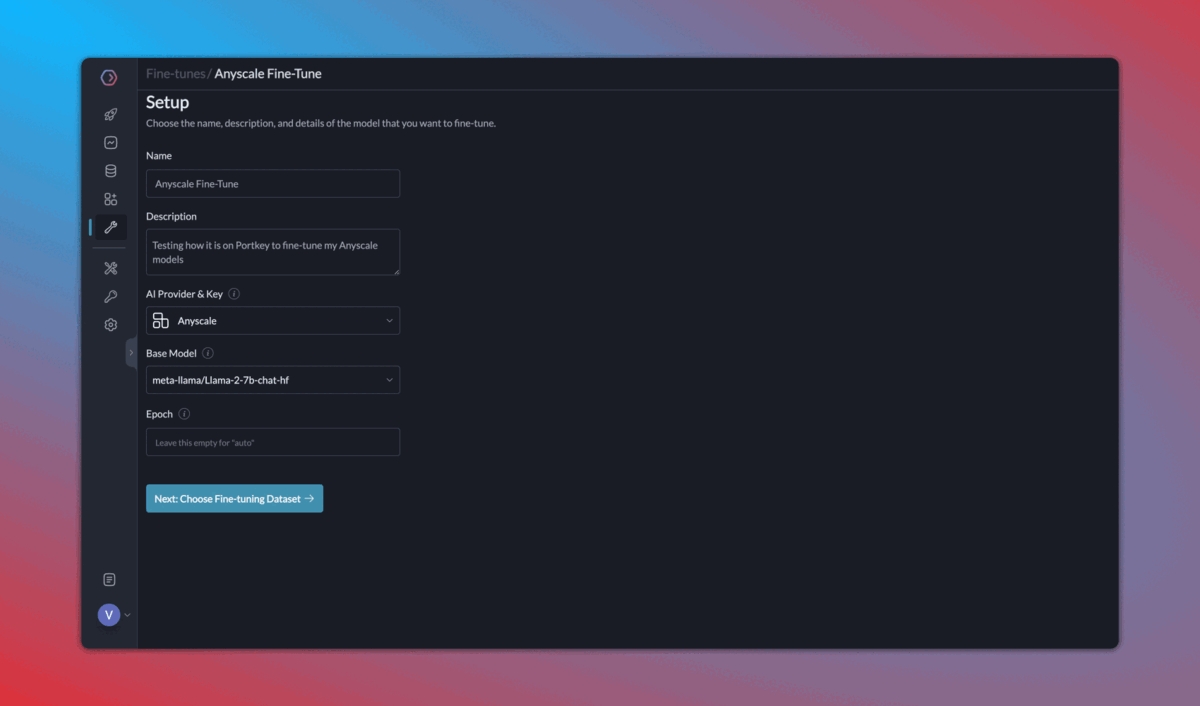

4. 持续微调

结论

Last updated